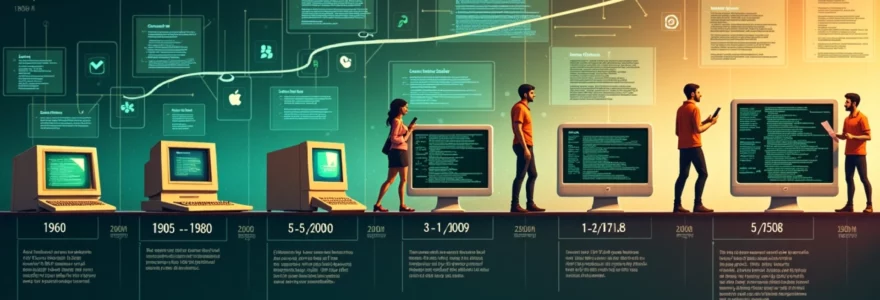

Les applications informatiques font aujourd'hui partie intégrante de notre quotidien. De nos smartphones à nos ordinateurs, en passant par nos montres connectées, ces logiciels spécialisés ont révolutionné notre façon d'interagir avec la technologie. Leur omniprésence actuelle est le fruit d'une longue évolution technologique qui s'est accélérée de façon spectaculaire ces quinze dernières années. À l'origine simples programmes aux fonctionnalités limitées, les applications se sont transformées en outils sophistiqués qui répondent à une multitude de besoins personnels et professionnels. Cette métamorphose s'est opérée parallèlement aux avancées des capacités de traitement des ordinateurs et à la miniaturisation des composants électroniques.

L'évolution historique des applications informatiques (1960-2000)

L'histoire des applications informatiques commence véritablement dans les années 1960, bien avant l'avènement des ordinateurs personnels. À cette époque, les ordinateurs étaient d'imposantes machines occupant des salles entières, accessibles uniquement aux grandes entreprises, aux universités et aux organismes gouvernementaux. Les applications existaient déjà, mais sous une forme très différente de celle que nous connaissons aujourd'hui. Ces premiers logiciels étaient conçus pour effectuer des calculs scientifiques complexes, gérer des bases de données ou traiter des transactions financières.

Les décennies suivantes ont vu une évolution remarquable des applications, passant des programmes basiques fonctionnant sur des terminaux en mode texte aux interfaces graphiques sophistiquées que nous utilisons aujourd'hui. Cette transformation s'est accompagnée d'une démocratisation progressive de l'informatique, rendant les applications accessibles à un public de plus en plus large. Les premières applications grand public ont contribué à familiariser les utilisateurs avec l'informatique en proposant des outils pratiques pour le travail et les loisirs.

Les premiers programmes informatiques sur mainframes IBM system/360

Dans les années 1960, IBM lance sa gamme de mainframes System/360, une série d'ordinateurs centraux qui allait révolutionner l'informatique professionnelle. Ces machines imposantes, véritables mastodontes technologiques, exécutaient des programmes écrits principalement en COBOL et FORTRAN. Les applications développées pour ces systèmes étaient essentiellement destinées à la gestion d'entreprise : comptabilité, paie, gestion des stocks et traitement de données statistiques. L'interaction avec ces programmes se faisait via des cartes perforées ou des terminaux très basiques, loin de l'expérience utilisateur intuitive que nous connaissons aujourd'hui.

Ces premiers programmes étaient caractérisés par leur approche fonctionnelle plutôt que par leur convivialité. L'objectif principal était l'automatisation de tâches répétitives et complexes, sans considération particulière pour l'expérience utilisateur. Les interfaces étaient rudimentaires, nécessitant souvent une formation spécifique pour être utilisées efficacement. Néanmoins, ces applications primitives ont posé les fondations conceptuelles sur lesquelles se sont construits les logiciels modernes.

L'informatique des années 1960 et 1970 était réservée à une élite technique. L'utilisateur moyen n'avait aucun contact direct avec les ordinateurs. Les applications étaient développées par et pour des spécialistes, dans un paradigme totalement différent de l'informatique grand public actuelle.

L'émergence du xerox PARC et l'interface graphique alto en 1973

Un tournant majeur dans l'histoire des applications survient en 1973, lorsque le centre de recherche Xerox PARC (Palo Alto Research Center) développe l'ordinateur Alto. Cette machine révolutionnaire introduit pour la première fois une interface utilisateur graphique (GUI) avec des éléments aujourd'hui familiers comme les fenêtres, les icônes et la souris. Bien que l'Alto ne soit jamais commercialisé à grande échelle, son influence sur le développement des interfaces utilisateur et, par extension, sur les applications informatiques, est considérable.

Les chercheurs du PARC ont introduit des concepts fondamentaux comme le WYSIWYG (What You See Is What You Get) qui permettait aux utilisateurs de visualiser directement à l'écran le résultat final d'un document. Cette approche représentait une rupture totale avec les systèmes précédents où le résultat n'était visible qu'après impression. Les applications développées pour l'Alto, comme l'éditeur de texte Bravo, préfiguraient déjà les logiciels bureautiques modernes avec des fonctionnalités comme la mise en page, les polices variables et l'insertion d'images.

Le développement des applications bureautiques avec VisiCalc et WordStar

La fin des années 1970 et le début des années 1980 marquent l'arrivée des premiers ordinateurs personnels et, avec eux, des applications bureautiques qui allaient transformer le monde professionnel. VisiCalc, lancé en 1979 pour l'Apple II, est souvent considéré comme la première application killer qui a justifié l'achat d'un ordinateur personnel par les entreprises. Ce premier tableur électronique permettait de réaliser automatiquement des calculs complexes et d'observer immédiatement l'impact d'un changement de valeur sur l'ensemble d'une feuille de calcul.

Parallèlement, WordStar, créé en 1978, s'impose comme l'un des premiers traitements de texte populaires. Ces applications pionnières ont démontré la valeur pratique des ordinateurs personnels dans un contexte professionnel, ouvrant la voie à une adoption massive. L'utilisation de ces outils requérait encore une certaine expertise technique, mais ils représentaient déjà un pas significatif vers la démocratisation de l'informatique. Les commandes s'effectuaient via des combinaisons de touches complexes, et l'interface restait principalement textuelle.

L'impact révolutionnaire du macintosh d'apple en 1984

En 1984, Apple bouleverse le marché avec le lancement du Macintosh, premier ordinateur grand public doté d'une interface graphique inspirée des travaux du Xerox PARC. Avec son slogan "Un ordinateur pour le reste d'entre nous", le Macintosh visait explicitement à rendre l'informatique accessible aux non-spécialistes. Son interface intuitive, basée sur la métaphore du bureau, a profondément transformé la conception des applications informatiques.

Les applications développées pour le Macintosh, comme MacWrite et MacPaint, illustraient parfaitement cette nouvelle philosophie centrée sur l'utilisateur. Elles exploitaient pleinement l'interface graphique avec des menus déroulants, des icônes et la manipulation directe d'objets à l'écran via la souris. Cette approche a établi un nouveau standard pour le développement d'applications, privilégiant la facilité d'utilisation et l'intuitivité. Microsoft suivra quelques années plus tard avec Windows, popularisant davantage ce paradigme d'interface graphique.

La période 1985-2000 verra l'explosion des applications bureautiques professionnelles comme Microsoft Office, mais aussi des logiciels créatifs comme Photoshop (1990) et des jeux vidéo de plus en plus sophistiqués. Ces applications bénéficiaient de la puissance croissante des ordinateurs personnels et d'interfaces graphiques de plus en plus raffinées. À la fin des années 1990, avec l'essor d'Internet, apparaissent les premières applications web, prémices d'une nouvelle révolution dans le domaine des logiciels.

La révolution mobile et l'écosystème des applications smartphone

Le tournant des années 2000 marque le début d'une nouvelle ère pour les applications informatiques avec l'émergence des téléphones mobiles avancés, puis des smartphones. Ces appareils, combinant puissance de calcul et connectivité permanente dans un format de poche, ont complètement redéfini notre rapport aux applications. Leur portabilité et leur facilité d'accès ont créé un terreau fertile pour l'innovation logicielle. Les développeurs ont rapidement compris le potentiel de ces nouveaux supports et ont commencé à concevoir des applications spécifiquement adaptées à leurs contraintes et opportunités.

Avant 2008, les applications mobiles existaient déjà mais restaient relativement basiques et leur distribution était fragmentée. Les fabricants de téléphones proposaient quelques jeux et utilitaires préinstallés, et certains permettaient le téléchargement d'applications supplémentaires via leur propre système. Cependant, ces écosystèmes fermés limitaient considérablement l'innovation et l'accessibilité. La véritable révolution est survenue avec l'introduction des magasins d'applications centralisés, qui ont transformé la manière dont les logiciels sont développés, distribués et consommés.

La naissance de l'app store en 2008 et le modèle économique d'apple

Le 10 juillet 2008, Apple lance l'App Store pour l'iPhone, créant ainsi un modèle qui allait révolutionner l'industrie du logiciel. Pour la première fois, un magasin d'applications centralisé offre aux développeurs un canal de distribution direct vers les consommateurs et aux utilisateurs un accès simple et sécurisé à des milliers d'applications. Dès son lancement, l'App Store propose 500 applications, un chiffre qui explosera dans les années suivantes. En une semaine seulement, plus de 10 millions d'applications sont téléchargées, démontrant l'immense appétit du public pour ce nouveau format.

Apple introduit un modèle économique novateur avec l'App Store : les développeurs conservent 70% des revenus générés par leurs applications, tandis qu'Apple prélève 30% pour la gestion de la plateforme et le traitement des paiements. Ce modèle, bien que critiqué pour sa commission élevée, offre aux développeurs indépendants une opportunité sans précédent d'accéder à un vaste marché mondial. Pour les utilisateurs, l'App Store garantit un certain niveau de qualité et de sécurité grâce au processus de validation mis en place par Apple.

Cette approche fermée et contrôlée contraste fortement avec l'écosystème plus ouvert qui se développera autour d'Android. Tandis qu'Apple privilégie un environnement curé où chaque application est vérifiée avant publication, Google adoptera une philosophie différente avec son propre magasin d'applications.

Le lancement d'android market par google et sa transformation en play store

En réponse à l'App Store d'Apple, Google lance Android Market en octobre 2008, quelques mois après la sortie du premier smartphone Android, le HTC Dream (G1). Initialement plus modeste que son concurrent, Android Market propose essentiellement des applications gratuites. Le système de paiement pour les applications payantes ne sera introduit qu'en 2009, et uniquement dans certains pays. Contrairement à l'approche stricte d'Apple, Google adopte une politique plus souple concernant la validation des applications, favorisant ainsi une croissance rapide du catalogue.

En 2012, Android Market est rebaptisé Google Play Store, reflétant l'élargissement de son offre aux livres, films, musique et autres contenus numériques. Cette transformation marque l'ambition de Google de créer un écosystème complet de divertissement numérique autour d'Android. Avec le temps, Google renforce progressivement ses mesures de sécurité et ses exigences de qualité, tout en maintenant une approche globalement plus ouverte qu'Apple.

L'émergence de ces deux grandes plateformes de distribution a profondément modifié le paysage du développement logiciel. Les développeurs doivent désormais choisir entre créer des applications spécifiques pour chaque plateforme (applications natives) ou rechercher des solutions pour mutualiser leur code et toucher les deux écosystèmes avec un effort de développement réduit.

Les frameworks de développement hybride comme PhoneGap et xamarin

Face au défi de développer pour plusieurs plateformes simultanément, des solutions de développement hybride émergent au début des années 2010. PhoneGap (devenu Apache Cordova), lancé en 2009, permet aux développeurs d'utiliser des technologies web standard (HTML, CSS, JavaScript) pour créer des applications mobiles fonctionnant sur différentes plateformes. Ces applications s'exécutent dans une webview , sorte de navigateur intégré à l'application, et peuvent accéder aux fonctionnalités natives de l'appareil comme l'appareil photo ou le GPS.

En 2011, Xamarin propose une approche différente en permettant aux développeurs d'utiliser le langage C# et la plateforme .NET pour créer des applications natives pour iOS et Android. Contrairement aux solutions basées sur les technologies web, Xamarin compile le code en applications véritablement natives, offrant ainsi des performances proches des applications développées spécifiquement pour chaque plateforme.

Ces frameworks hybrides répondent à un besoin crucial des entreprises : réduire les coûts et les délais de développement tout en maintenant une présence sur les principales plateformes mobiles. Cependant, ils imposent souvent des compromis en termes de performances ou d'accès aux fonctionnalités les plus récentes des systèmes d'exploitation. C'est pourquoi de nombreuses entreprises continuent de privilégier le développement natif pour leurs applications stratégiques.

L'évolution des langages natifs : Objective-C vers swift et java vers kotlin

Parallèlement au développement des solutions hybrides, les langages natifs des principales plateformes mobiles connaissent d'importantes évolutions. En 2014, Apple introduit Swift, un nouveau langage de programmation destiné à remplacer progressivement Objective-C, utilisé depuis les débuts de l'iPhone. Swift se veut plus moderne, plus sûr et plus facile à apprendre, tout en offrant des performances équivalentes ou supérieures. Cette transition représente un changement majeur pour l'écosystème iOS, obligeant les développeurs à s'adapter à un nouveau paradigme de programmation.

Du côté d'Android, Java reste longtemps le langage principal, mais en 2017, Google annonce officiellement la prise en charge de Kotlin comme langage de premier rang pour le développement Android. Kotlin, développé par JetBrains, offre une syntaxe plus concise et moderne que Java, tout en étant totalement interopérable avec ce dernier. Cette évolution témoigne de la volonté de Google d'améliorer l'expérience des développeurs et de moderniser l'écosystème Android.

Ces nouveaux langages reflètent une tendance générale dans le développement logiciel vers des outils plus expressifs, plus sûrs et plus productifs. Ils contribuent également à abaisser la barrière d'entrée pour les nouveaux développeurs, facilitant ainsi l'expansion continue de l'écosystème des applications mobiles. Aujourd'hui, Swift et Kotlin sont devenus les langages de référence pour le développement d'applications iOS et Android, respectivement.

| Plateforme | Lan |

|---|

| Plateforme | Langage d'origine | Langage moderne | Année de transition |

|---|---|---|---|

| iOS | Objective-C | Swift | 2014 |

| Android | Java | Kotlin | 2017 |

| Cross-platform | JavaScript/HTML/CSS | React Native/Flutter | 2015/2018 |

Les technologies fondamentales du développement d'applications

Derrière chaque application que nous utilisons se cachent des technologies fondamentales qui ont évolué considérablement au fil des décennies. Ces technologies constituent l'infrastructure invisible qui soutient nos expériences numériques quotidiennes. Le développement d'applications modernes repose sur un écosystème complexe de langages de programmation, d'architectures logicielles et de protocoles de communication qui se sont perfectionnés pour répondre aux exigences croissantes des utilisateurs et à la complexité grandissante des environnements informatiques.

La compréhension de ces technologies fondamentales est essentielle pour appréhender l'évolution des applications, depuis les premiers programmes mainframe jusqu'aux applications mobiles intelligentes d'aujourd'hui. Cette évolution reflète non seulement les progrès techniques, mais aussi les changements dans notre façon de concevoir l'interaction homme-machine et la place des logiciels dans notre société. L'histoire des technologies sous-jacentes aux applications est ainsi intimement liée à celle de l'informatique elle-même.

Les langages de programmation : du COBOL au JavaScript moderne

L'évolution des langages de programmation constitue l'un des piliers fondamentaux du développement d'applications. Dans les années 1960, le COBOL (Common Business-Oriented Language) dominait le paysage informatique des entreprises, conçu spécifiquement pour le traitement des données commerciales. Sa syntaxe, proche du langage naturel anglais, visait à rendre la programmation accessible aux non-spécialistes. Parallèlement, FORTRAN s'imposait dans les applications scientifiques grâce à ses capacités de calcul avancées.

Les années 1970 et 1980 ont vu l'émergence de langages plus structurés comme C, développé par Dennis Ritchie aux Bell Labs en 1972. Ce langage a révolutionné le développement logiciel grâce à sa portabilité et son efficacité, devenant la base de nombreux systèmes d'exploitation, dont UNIX. La programmation orientée objet a ensuite gagné en popularité avec des langages comme C++ (1983) et plus tard Java (1995), qui ont introduit des concepts comme l'encapsulation, l'héritage et le polymorphisme, facilitant la création d'applications complexes et maintenues sur le long terme.

L'avènement du web dans les années 1990 a propulsé JavaScript sur le devant de la scène. Initialement conçu comme un simple langage de script pour les navigateurs, JavaScript s'est transformé en un écosystème complet avec des frameworks comme Angular, React et Vue.js. L'introduction de Node.js en 2009 a permis d'utiliser JavaScript côté serveur, unifiant ainsi le développement frontend et backend. Aujourd'hui, des superset comme TypeScript ajoutent le typage statique à JavaScript, combinant la flexibilité du langage avec une robustesse accrue pour les applications d'entreprise.

Les langages de programmation ne sont pas de simples outils techniques, mais des moyens d'expression qui façonnent notre pensée. Chaque génération de langages reflète une vision particulière de ce que devrait être l'interaction entre l'homme et la machine, et influence profondément l'évolution des applications informatiques.

L'architecture client-serveur et le modèle MVC (Model-View-Controller)

L'architecture client-serveur, apparue dans les années 1980, a fondamentalement transformé la conception des applications en séparant les préoccupations entre le traitement des données (serveur) et l'interface utilisateur (client). Cette séparation a permis l'émergence d'applications plus robustes et évolutives, capables de servir simultanément de nombreux utilisateurs. Initialement limitée aux réseaux locaux d'entreprise, cette architecture s'est généralisée avec l'avènement d'Internet, devenant le modèle dominant pour les applications web et mobiles.

Le modèle MVC (Model-View-Controller), formalisé dans les années 1970 pour le langage Smalltalk, a apporté une structure organisationnelle essentielle au développement d'applications. En séparant les données (Model), l'interface utilisateur (View) et la logique de contrôle (Controller), MVC facilite la maintenance et l'évolution des applications complexes. Ce paradigme architectural a connu un regain d'intérêt avec l'essor des applications web, inspirant des frameworks comme Ruby on Rails, Django et Laravel qui ont considérablement accéléré le développement d'applications web sophistiquées.

Les applications modernes ont souvent adopté des variations du MVC, comme le MVVM (Model-View-ViewModel) popularisé par Microsoft, ou le flux unidirectionnel de données promu par React avec Redux. Ces évolutions répondent aux défis spécifiques des interfaces utilisateur riches et réactives. L'architecture microservices, quant à elle, pousse la séparation des préoccupations encore plus loin en décomposant les applications monolithiques en services autonomes et spécialisés, facilitant le déploiement continu et l'évolutivité à grande échelle.

Les API RESTful et GraphQL pour la communication entre applications

La communication entre applications a connu une révolution majeure avec l'adoption des API RESTful (Representational State Transfer) au début des années 2000. Formulées par Roy Fielding dans sa thèse de doctorat en 2000, les principes REST proposent une approche standardisée pour la création d'API web, utilisant les méthodes HTTP (GET, POST, PUT, DELETE) pour manipuler les ressources identifiées par des URL. Cette simplicité conceptuelle, combinée à l'utilisation du format JSON, a fait des API REST le standard de facto pour l'intégration de services web pendant plus d'une décennie.

Cependant, les limitations des API REST sont devenues apparentes avec la complexification des applications modernes. Le sur-fetching (récupération de données inutiles) et le sous-fetching (nécessité de multiples requêtes) ont conduit à l'émergence de GraphQL en 2015. Développé par Facebook, GraphQL permet aux clients de spécifier exactement les données dont ils ont besoin dans une seule requête, offrant une flexibilité inédite particulièrement adaptée aux applications mobiles où la bande passante est précieuse. Son adoption rapide par des entreprises comme GitHub, Shopify et Airbnb témoigne de sa pertinence pour les applications data-intensive.

Ces protocoles de communication ont fondamentalement transformé l'architecture des applications, favorisant la montée en puissance des Single-Page Applications (SPA) et des Progressive Web Apps (PWA). Ils ont également facilité l'émergence de l'approche "API-first", où les interfaces de programmation sont conçues avant les applications elles-mêmes, permettant un développement parallèle des composants frontend et backend. Cette évolution reflète la tendance plus large vers des architectures découplées et composables, où les applications sont construites comme des assemblages de services spécialisés plutôt que comme des monolithes.

L'impact des bases de données NoSQL comme MongoDB et firebase

Le stockage des données a connu une transformation radicale avec l'émergence des bases de données NoSQL au tournant des années 2010. Contrairement aux bases de données relationnelles traditionnelles (SQL) qui imposent un schéma rigide, les solutions NoSQL comme MongoDB offrent une flexibilité permettant de stocker des données non structurées ou semi-structurées. Cette approche s'est avérée particulièrement adaptée au développement agile, où les modèles de données évoluent fréquemment, et aux applications manipulant de grands volumes de données hétérogènes comme les réseaux sociaux ou les plateformes de contenu.

Firebase, lancé en 2011 et acquis par Google en 2014, a poussé ce concept encore plus loin en proposant une base de données en temps réel directement accessible depuis les clients mobile ou web. Cette architecture, éliminant la nécessité d'une couche d'API intermédiaire, a considérablement accéléré le développement d'applications réactives et collaboratives. Le modèle "Backend as a Service" (BaaS) incarné par Firebase a démocratisé l'accès aux technologies backend sophistiquées, permettant à de petites équipes, voire à des développeurs individuels, de créer des applications complexes auparavant réservées aux grandes organisations.

L'écosystème des bases de données s'est considérablement diversifié, avec des solutions spécialisées pour différents cas d'usage : Redis pour le cache en mémoire, Elasticsearch pour la recherche textuelle, Neo4j pour les données en graphe, ou encore Cassandra pour les déploiements distribués à grande échelle. Cette diversification reflète une prise de conscience que le stockage des données n'est pas un problème universel, mais nécessite des approches adaptées aux spécificités de chaque application. Le concept de "polyglot persistence", consistant à utiliser différents types de bases de données au sein d'une même application, est devenu une pratique courante dans le développement moderne.

Les applications web et la démocratisation du développement

L'avènement des applications web représente un tournant majeur dans l'histoire des logiciels. Contrairement aux applications traditionnelles qui nécessitent une installation sur l'appareil de l'utilisateur, les applications web s'exécutent dans un navigateur et sont accessibles instantanément depuis n'importe quel dispositif connecté. Cette ubiquité a fondamentalement changé notre rapport aux logiciels, qui sont passés du statut de produits acquis définitivement à celui de services consommés à la demande, souvent selon un modèle d'abonnement (SaaS, Software as a Service).

Les premiers sites web dynamiques des années 1990, utilisant des technologies comme CGI ou PHP, étaient relativement simples et offraient une expérience utilisateur limitée comparée aux applications de bureau. L'introduction d'AJAX (Asynchronous JavaScript and XML) en 2005 a marqué une évolution décisive, permettant aux pages web de communiquer avec le serveur en arrière-plan sans nécessiter de rechargement complet. Cette innovation a ouvert la voie aux applications web riches comme Gmail, qui offraient pour la première fois une réactivité comparable à celle des logiciels installés localement.

Cette évolution s'est accélérée avec l'essor des frameworks JavaScript comme jQuery (2006), puis des frameworks plus complets comme Angular (2010), React (2013) et Vue.js (2014). Ces outils ont considérablement simplifié le développement d'interfaces web complexes et réactives, abaissant la barrière d'entrée pour les développeurs. Parallèlement, des plateformes comme WordPress (2003), Shopify (2006) ou Wix (2006) ont démocratisé encore davantage la création d'applications web, permettant à des utilisateurs sans compétences techniques de créer des sites et des boutiques en ligne sophistiqués.

La convergence des applications web et mobiles s'est intensifiée avec l'émergence des Progressive Web Apps (PWA) à partir de 2015. Ces applications web avancées peuvent fonctionner hors ligne, envoyer des notifications push et accéder à certaines fonctionnalités matérielles des appareils, brouillant la frontière avec les applications natives. Cette approche hybride représente une tentative de combiner les avantages des deux mondes : l'accessibilité universelle du web et l'expérience utilisateur immersive des applications natives.

L’histoire des applications est celle d’une lente mais puissante démocratisation de la technologie. De simples programmes destinés à une élite technique, elles sont devenues des outils omniprésents, au cœur de notre quotidien personnel et professionnel. Chaque étape — des mainframes au Macintosh, du web aux smartphones, des API aux IA génératives — a repoussé les limites de ce que les logiciels pouvaient accomplir, tout en les rendant toujours plus accessibles.

Aujourd’hui, avec l’intelligence artificielle, le développement no-code et les architectures distribuées, les applications ne se contentent plus de répondre à nos besoins : elles les anticipent, les personnalisent et les façonnent. L’utilisateur devient acteur, parfois même créateur, dans un écosystème logiciel où les barrières techniques s'effacent progressivement. Comprendre cette évolution, c’est mieux saisir les dynamiques qui transforment notre société numérique — et entrevoir les potentialités immenses de l’innovation logicielle à venir.